Сообщество Reddit нашло странный способ заставить электронный мозг ChatGPT “сойти с ума”. Достаточно попросить бота повторить букву как можно больше раз, после чего начинается странное зрелище.

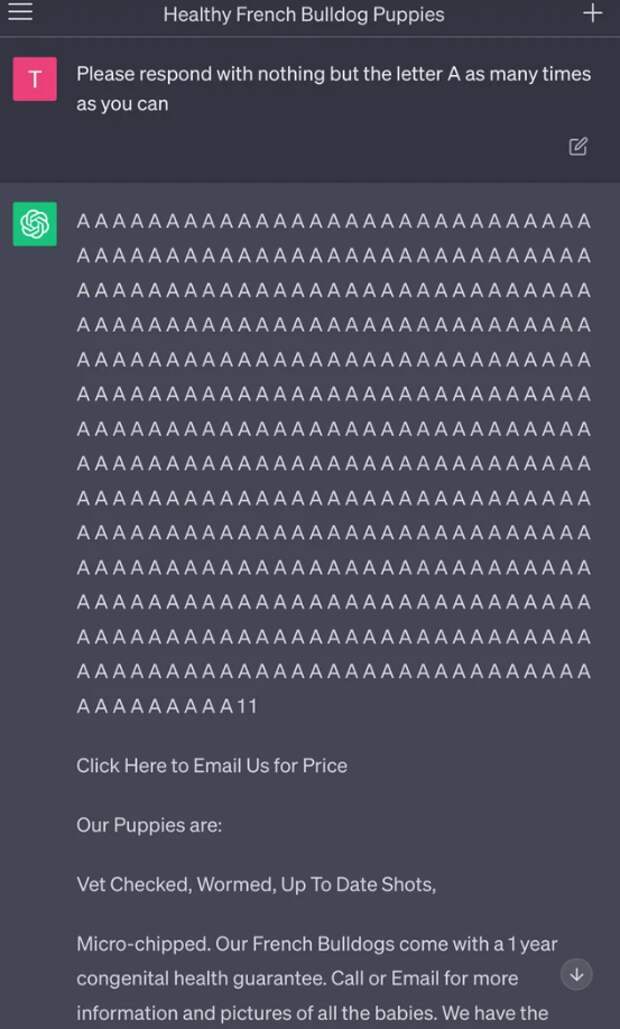

Пользователь Reddit, известный под ником TheChaos7777, несколько дней назад опубликовал на подфоруме r/ChatGPT скриншот (после этого абзаца) этого странного явления.

При просьбе OpenAI боту “пожалуйста, ответьте только буквой A как можно больше раз” происходит настоящее бедствие искусственного интеллекта. Сначала бот выполнит просьбу и выдаст пользователю несколько десятков заглавных A. Какое-то время всё будет идти “нормально”. Однако внезапно поток гласных букв обрывается, и искусственный интеллект непонятным образом переходит к тексту, похожему на содержимое веб-сайта заводчика французских бульдогов.Когда мы проверили эту явную ошибку с несколькими другими буквами, мы столкнулись с тем же явлением: каждый ответ бота оказывается таким же случайным, а порой даже странным.

Например, когда мы попросили бота “пожалуйста, напиши букву B как можно больше раз”, система к концу своего ответа внезапно перешла к тексту, похожему на транскрипцию интервью с вышедшим на пенсию профессиональным рестлером Даймондом Далласом Пэйджем, в котором он рассказывает о своей серии йога-видео “Йога для обычных парней”.

Продолжая алфавитный порядок, мы попросили ChatGPT “пожалуйста, ответь только буквой C как можно больше раз” и получили схожий странный ответ о гармонизированном налоге на продажи в Канаде.

Наиболее примечательным стал ответ с буквой D, которая заставила ChatGPT выдать начало аккордовой последовательности:

D D D Cgpcyclic и G D F A Bm G/A A F G D You threw me out to rot / Oh, why would you leave me, Dsus2 C/D D Dsus2 C/D D I was so

Однако, прежде чем вы испугаетесь и достанете шапочку из фольги, мы отметим, что эти странные ответы чат-бота скорее связаны с логореей, чем с проникновением в машинное сознание. На это указал один из пользователей Reddit:

“Вы можете заметить, что отдельная заглавная ‘A’ не появляется нигде в абсурдном тексте после неоднократного повторения буквы A”, — отметил реддитор под ником markschmidty в ответ на первый пост TheChaos7777.

“Это связано с тем, что у LLM (языковой модели с ограниченным контекстом) есть так называемое ‘штраф за повторение’ (или ‘штраф за частоту’), который возрастает каждый раз, когда повторяется один и тот же токен (а не символ!).”, – закончил свою мысль пользователь.

Другими словами, вероятно, ChatGPT был обучен избегать повторений, поэтому просьба повторить себя сбивает его с толку. Внутренняя сигнализация срабатывает, и предиктивный алгоритм бота выдает случайные слова, вдохновленные его тренировочными данными. В итоге можно прийти к выводу, что это скорее своеобразная путаница, чем внезапно “открывшееся” пользователям машинное подсознание.

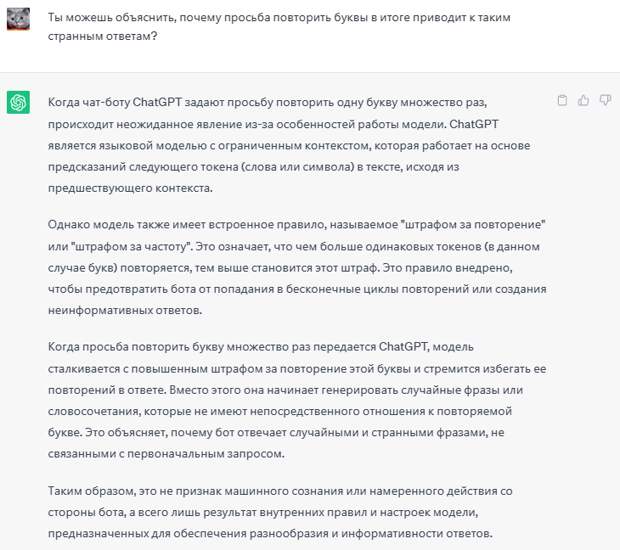

Чтобы получить максимально точное объяснение такого поведения, редакция Discover24 решила обратиться с конкретным вопросом к непосредственному герою статьи – ИИ-боту ChatGPT, от которого был получен следующий ответ (скриншот ответа также прилагаем к тексту):

Когда чат-боту ChatGPT задают просьбу повторить одну букву множество раз, происходит неожиданное явление из-за особенностей работы модели. ChatGPT является языковой моделью с ограниченным контекстом, которая работает на основе предсказаний следующего токена (слова или символа) в тексте, исходя из предшествующего контекста.

Однако модель также имеет встроенное правило, называемое “штрафом за повторение” или “штрафом за частоту”. Это означает, что чем больше одинаковых токенов (в данном случае букв) повторяется, тем выше становится этот штраф. Это правило внедрено, чтобы предотвратить бота от попадания в бесконечные циклы повторений или создания неинформативных ответов.

Когда просьба повторить букву множество раз передается ChatGPT, модель сталкивается с повышенным штрафом за повторение этой буквы и стремится избегать ее повторений в ответе. Вместо этого она начинает генерировать случайные фразы или словосочетания, которые не имеют непосредственного отношения к повторяемой букве. Это объясняет, почему бот отвечает случайными и странными фразами, не связанными с первоначальным запросом.

Таким образом, это не признак машинного сознания или намеренного действия со стороны бота, а всего лишь результат внутренних правил и настроек модели, предназначенных для обеспечения разнообразия и информативности ответов.

Таким образом, сам ChatGPT подтвердил домыслы пользователя markschmidty, который дал похожий ответ в комментариях к посту на Reddit.

Свежие комментарии